Infrastructure pour l'IA

Exécutez plus rapidement les workloads d'IA les plus exigeants, y compris l'IA générative, la vision par ordinateur et l'analyse prédictive, où que vous soyez dans notre cloud distribué. Utilisez Oracle Cloud Infrastructure (OCI) Supercluster pour évoluer jusqu'à 32 768 GPU aujourd'hui et bientôt 131 072 GPU*.

Découvrez comment accélérer l'entraînement et l'inférence pour l'IA

Pourquoi utiliser l'infrastructure d'IA d'OCI ?

Performance et valeur de l'IA de pointe

L'infrastructure d'IA d'OCI offre la performance et la valeur les plus élevées pour tous les workloads d'IA, y compris les l'inférence, l'entraînement et les assistants d'IA.

Stockage pour le calcul haute performance

Tirez parti des cibles de montage haute performance (HPMT) pour un débit soutenu pouvant atteindre 500 Gb/s. Utilisez une capacité de stockage locale de 61,44 To, la plus élevée du secteur pour les instances avec des GPU NVIDIA H100.

Mettre en place une IA souveraine

Le cloud distribué d'Oracle vous permet de déployer une infrastructure d'IA n'importe où pour répondre aux exigences en matière de performances, de sécurité et de souveraineté de l'IA.

Capture d'écran représentant les zones de calcul et de stockage connectées par des lignes pour la mise en réseau en clusters. Tout à gauche, il y a quatre boîtes de calcul et deux pour le stockage du plus petit cluster avec 16 000 GPU NVIDIA H100. À droite, il y a 8 boîtes de calcul et 4 boîtes de stockage pour 32 000 GPU NVIDIA A100 dans un cluster. Ensuite, il y a 16 boîtes de calcul et 8 boîtes de stockage pour 64 000 GPU NVIDIA H200. Enfin, tout à droite, il y a 32 boîtes de calcul et 16 boîtes de stockage pour 128 000 GPU NVIDIA Blackwell et Grace Blackwell. L'évolutivité d'OCI Supercluster peut être multipliée par 8, de la plus petite configuration de 16 000 GPU tout à gauche jusqu'à la plus grande configuration de 128 000 GPU tout à droite.

Capture d'écran représentant les zones de calcul et de stockage connectées par des lignes pour la mise en réseau en clusters. Tout à gauche, il y a quatre boîtes de calcul et deux pour le stockage du plus petit cluster avec 16 000 GPU NVIDIA H100. À droite, il y a 8 boîtes de calcul et 4 boîtes de stockage pour 32 000 GPU NVIDIA A100 dans un cluster. Ensuite, il y a 16 boîtes de calcul et 8 boîtes de stockage pour 64 000 GPU NVIDIA H200. Enfin, tout à droite, il y a 32 boîtes de calcul et 16 boîtes de stockage pour 128 000 GPU NVIDIA Blackwell et Grace Blackwell. L'évolutivité d'OCI Supercluster peut être multipliée par 8, de la plus petite configuration de 16 000 GPU tout à gauche jusqu'à la plus grande configuration de 128 000 GPU tout à droite.

OCI Supercluster avec les GPU NVIDIA Blackwell et Hopper

Jusqu'à 131 072 GPU, 8 fois plus d'évolutivité

Les innovations de structure réseau permettront à OCI Supercluster d'atteindre jusqu'à 131 072 GPU NVIDIA B200, 100 000 GPU Blackwell dans les superpuces NVIDIA Grace Blackwell et 65 536 GPU NVIDIA H200. Obtenez jusqu'à 8 fois plus d'évolutivité que les limites actuelles pour OCI Supercluster avec les GPU NVIDIA A100 et H100.

Infrastructure OCI pour tous vos besoins d'IA

Que vous cherchiez à effectuer des déductions ou des ajustements, ou à entraîner des modèles à grande échelle pour l'IA générative, OCI offre des options de cluster de GPU bare metal et de machine virtuelle de pointe, optimisées par un réseau à très large bande passante et un stockage à hautes performances pour répondre à vos besoins en IA.

Les innovateurs en matière d'IA tirent parti d'OCI pour héberger, entraîner et inférer des modèles d'IA nouvelle génération.

Découvrez OCI Supercluster pour un entraînement d'IA à grande échelle

Disponible maintenant : clusters évolutifs et massifs avec des GPU NVIDIA H100, A100 et L40S

Calcul

• 8 GPU NVIDIA H100 ; SSD NVMe 61,44 To par nœud

8 GPU NVIDIA A100 ; SSD NVMe 27,2 To par nœud

• 4 GPU NVIDIA L40S ; SSD 7,38 To NVMe par nœud

Stockage

• Stockage de blocs : jusqu'à 32 To par volume

• Stockage d'objets : jusqu'à 10 TiB par objet

• Stockage de fichiers : jusqu'à 8 Eo par système de fichiers

• Clusters de stockage avec des formes d'E/S denses

Mise en réseau

• RDMA sur Ethernet Convergé (RoCE v2)

• Peu de microsecondes de latence entre les nœuds

• Bande passante inter-nœuds OCI Supercluster :

o NVIDIA H100 : 3200 Gb/s

o NVIDIA A100 : 1600 Gb/s

o NVIDIA L40S : 800 Gb/s

Le calcul pour Supercluster

Les instances bare metal OCI alimentées par les GPU NVIDIA L40S, H100 et A100 permettent aux clients d'exécuter de grands modèles d'IA pour des cas d'utilisations tels que le deep learning, l'IA conversationnelle et l'IA générative. Avec OCI Supercluster, les clients peuvent évoluer jusqu'à 32 768 GPU A100, 16 384 GPU H100 et 3 840 GPU L40S par cluster.

Agrandir+

La mise en réseau par Supercluster

La mise en réseau de clusters RDMA à haut débit alimentée par les cartes d'interface réseau NVIDIA ConnectX avec RDMA sur la version 2 de l'ethernet convergé vous permet de créer de grands clusters d'instances GPU avec la même mise en réseau à très faible latence et la même évolutivité des applications attendue on-premises.

Vous ne payez pas de frais supplémentaires pour la capacité RDMA, le stockage de blocs ou la bande passante réseau, et les 10 premiers To de sortie sont gratuits.

Agrandir+

Le stockage pour OCI Supercluster

Grâce à OCI Supercluster, les clients peuvent accéder au stockage local, de blocs, d'objets et de fichiers pour le calcul exaflopique. Parmi les principaux fournisseurs de cloud, OCI offre la capacité la plus élevée de stockage NVMe local à hautes performances pour des points de reprise plus fréquents pendant les entraînements, ce qui permet une récupération plus rapide en cas de défaillance.

Les systèmes de fichiers HPC, y compris BeeGFS, GlusterFS, Lustre et WEKA, peuvent être utilisés pour l'entraînement d'IA à grande échelle sans compromettre les performances.

Comment OCI Supercluster fonctionne-t-il ?

Pradeep Vincent, Architecte technique en chef, explique comment OCI Supercluster optimise l'entraînement et l'inférence des modèles de machine learning en s'adaptant à des dizaines de milliers de GPU NVIDIA.

Cas d'usage typique de l'infrastructure d'IA

- Entraînement et inférence de deep learning

- Détection des fraudes augmentée par l'IA

- Analyse d'images médicales basée sur l'IA

- Utilisation de l'IA pour accélérer la découverte de médicaments

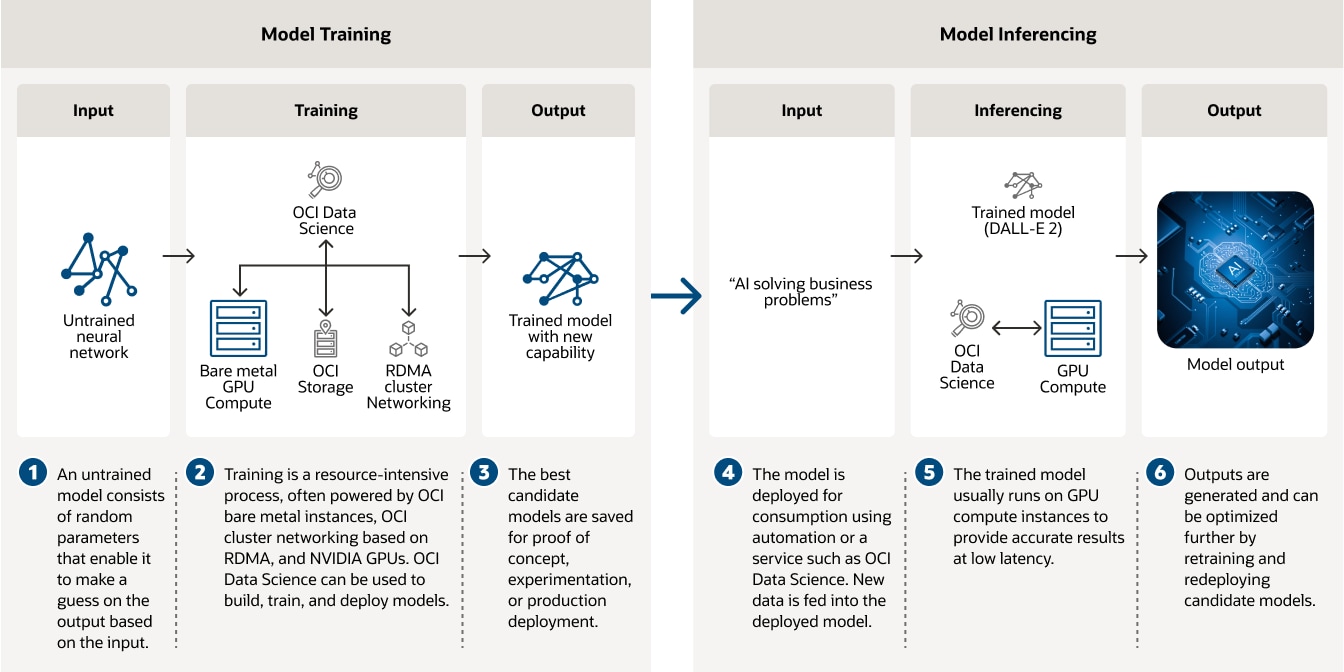

Entraînez des modèles d'IA sur des instances bare metal OCI optimisées par des GPU, des réseaux de clusters RDMA et OCI Data Science.

La protection des milliards de transactions financières qui se produisent chaque jour nécessite des outils d'IA améliorés capables d'analyser de grandes quantités de données client historiques. Les modèles d'IA exécutés sur OCI Compute alimentés par des GPU NVIDIA, ainsi que des outils de gestion de modèles tels qu'OCI Data Science et d'autres modèles open source aident les institutions financières à réduire la fraude.

L'IA est souvent utilisée pour analyser divers types d'images médicales (comme les rayons X et les IRM) dans un hôpital. Les modèles entraînés peuvent aider à hiérarchiser les cas nécessitant une révision immédiate par un radiologue et à rapporter des résultats concluants sur d'autres.

La découverte de médicaments est un processus long et coûteux qui peut prendre de nombreuses années et coûter des millions de dollars. En tirant parti de l'infrastructure et de l'analyse de l'IA, les chercheurs peuvent accélérer la découverte de médicaments. En outre, OCI Compute s'appuie sur des GPU NVIDIA ainsi que sur des outils de gestion des workflows d'IA tels que BioNeMo pour permettre aux clients de traiter et de prétraiter leurs données.

Témoignages client sur l'infrastructure de l'IA

Introduction à l'infrastructure d'IA d'OCI

Essayez Oracle AI gratuitement pendant 30 jours

Oracle offre un niveau gratuit pour la plupart des services d'IA ainsi qu'un compte d'essai gratuit avec 300 USD de crédits pour tester ses services cloud complémentaires. Les services d'IA comprennent un ensemble d'offres, incluant l'IA générative, avec des modèles de machine learning prédéfinis qui permettent aux développeurs d'appliquer plus facilement l'IA aux applications et aux opérations métier.

-

Quels services d'IA ou de machine learning d'Oracle offrent un niveau gratuit ?

- OCI Speech

- OCI Language

- OCI Vision

- OCI Document Understanding

- Le machine learning dans Oracle Database

- OCI Data Labeling

Vous n'avez à payer que des frais de calcul et de stockage pour OCI Data Science.

Ressources complémentaires

En savoir plus sur la mise en réseau de clusters RDMA, les instances GPU, les serveurs bare metal, etc.

Découvrez combien vous pouvez réaliser des économies avec OCI

La tarification d'Oracle Cloud est simple, avec des tarifs faibles homogènes dans le monde entier et prenant en charge un large éventail de cas spécifiques. Pour estimer votre tarif réduit, consultez l’estimateur de coûts et configurez les services en fonction de vos besoins.

Mise en contact avec des experts de l'IA

Obtenez de l'aide pour créer votre prochaine solution d'IA ou déployer votre workload sur l'infrastructure d'IA d'OCI.

-

Il peut répondre à des questions telles que :

- Comment se lancer avec Oracle Cloud ?

- Quels types de workloads d'IA puis-je exécuter sur OCI ?

- Quels types de services d'IA OCI propose-t-il ?